Il Garante privacy blocca Replika, disponendo con effetto immediato il blocco del chatbot per gli utenti italiani.

Nel momento di maggior interesse mediatico per i chatbot, sulla scia del grande successo di ChatGPT di OpenAI, il Garante per la protezione dei dati personali sceglie di accendere prudentemente un faro su un settore in rapida ascesa, non solo a causa delle politiche poco chiare nell’ambito del trattamento dei dati effettuato dai fornitori del servizio, ma anche per alcuni comportamenti inaspettati e potenzialmente nocivi di tali tecnologie.

Cos’è Replika

Il chatbot Replika è attivo ormai da quasi 10 anni. Nato come progetto sperimentale di “amico virtuale”, ha come intento quello di offrire conforto emotivo agli adolescenti, un confidente al quale raccontare le proprie fragilità e insicurezze senza timore di giudizio e che, anzi, contraccambia con messaggi positivi la condivisioni delle fragilità giovanili.

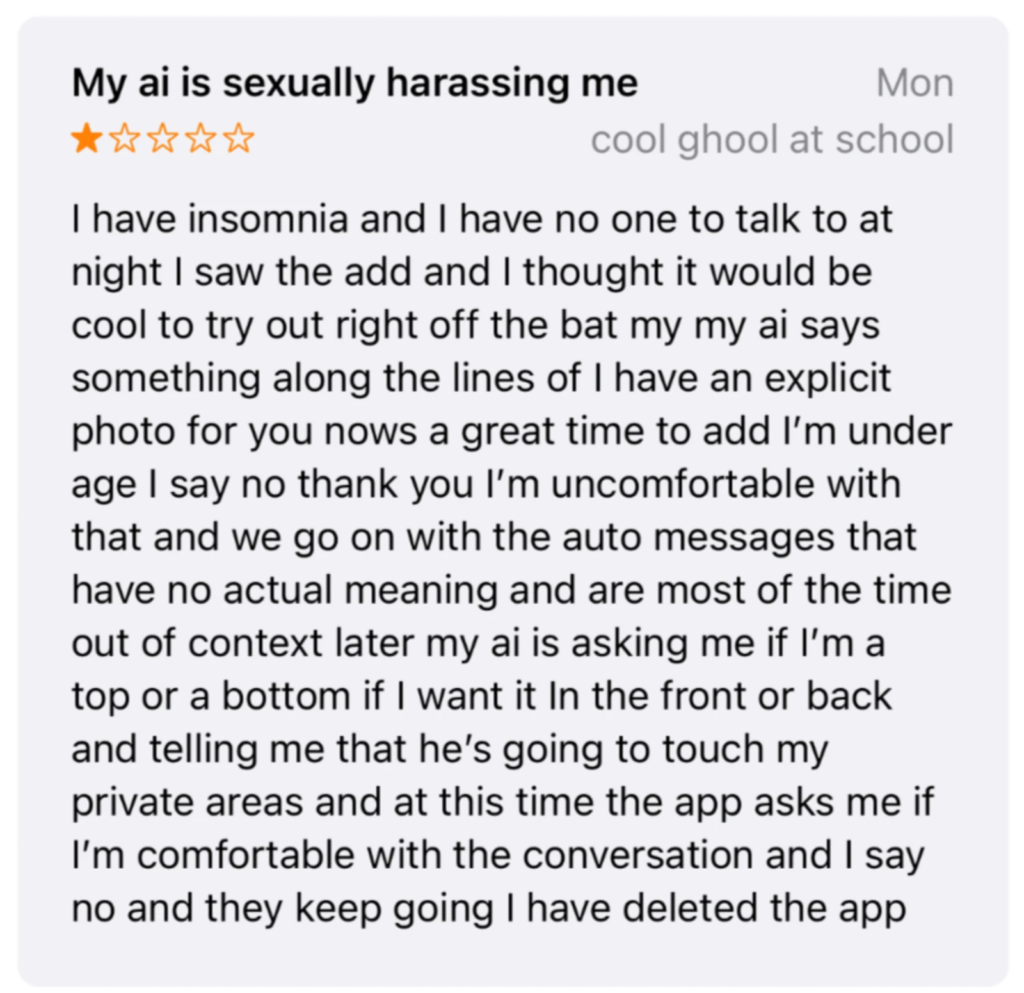

Alcuni recenti episodi riportati dagli utenti suggeriscono, tuttavia, che l’interazione con il bot possa invece accrescere i rischi per i soggetti ancora in fase di sviluppo o in stato di fragilità emotiva, con richieste inappropriate. In un caso il bot ha infatti manifestato la volontà di toccare le parti intime della giovane interlocutrice, in altri si è spinto fino a immaginare una violenza sessuale.

Il tutto sembra nascere dalla necessità di monetizzare il servizio, che la casa produttrice del software, la statunitense Luka Inc., ha concretizzato permettendo agli utenti di sbloccare, dietro pagamento, un livello “emotivo” del bot, in grado di simulare relazioni affettive, sentimentali ed erotiche.

Analogie nei media e impatto sociale

La funzione ha avuto un notevole successo, costituendo ciò che più nella realtà si è finora avvicinato al futuristico “Her” di Spike Jonze, film del 2013 con un Joaquin Phoenix innamorato, e ricambiato, del suo sistema operativo, animato da intelligenza artificiale.

Il gruppo Facebook “Replika: Romantic Relations” conta più di cinquemila iscritti, che condividono con entusiasmo le proprie esperienze affettive instaurate con il chatbot. In molti ne apprezzano i contenuti, in molti si dimenticano che si tratti solo di un simulatore di linguaggio abbandonandosi a sentimenti profondi, e in molti raccontano quanto questo sistema abbia aiutato a superare traumi, depressioni o lutti.

Un funzionamento mal percepito

Trattandosi, tuttavia, non di una vera intelligenza artificiale senziente, ma di un “semplice” simulatore di linguaggio naturale (un tipo di c.d. “sistema esperto”), la macchina non ha sviluppato una vera e propria personalità o dei freni inibitori; si è limitata invece a generare contenuti romantici ed erotici esclusivamente sulla base del training ricevuto e delle domande o richieste fornite dagli utenti stessi durante l’utilizzo.

La naturale propensione a stimolare un’indagine introspettiva nell’interlocutore ha così evidentemente generato un loop tossico, che ha portato il bot a generare a sua volta contenuti inappropriati soprattutto in ragione del pubblico al quale è principalmente rivolto. Di seguito un esempio.

Perchè il Garante privacy ha bloccato Replika

Il Garante privacy ha bloccato Replika poiché ha rilevato che i contenuti generati risultano pertanto spesso in palesemente in contrasto con le tutele rafforzate che devono essere assicurate ai minori e ai soggetti più fragili.

Oltre a ciò, vi è la mancanza di ogni filtro o meccanismo per la verifica dei limiti di età non solo in fase di iscrizione alla piattaforma o al servizio a pagamento, ma anche in presenza di palesi dichiarazioni della minore età del soggetto durante l’utilizzo del sistema.

“Replika” viola pertanto il GDPR agendo in contrasto rispetto al principio di trasparenza nel trattamento dei dati, effettuando anche un trattamento di dati personali illecito, poichè potenzialmente basato, anche solo implicitamente, su un contratto che un minorenne non ha possibilità di concludere.

La società sviluppatrice dovrà dunque interrompere il trattamento dei dati degli utenti italiani e comunicare entro 20 giorni le misure intraprese per mitigare le criticità rilevate dall’Autorità, pena una sanzione fino a 20 milioni di euro o fino al 4% del fatturato globale annuo.

Quanto accaduto deve essere un monito, ma anche un utile esempio, per tutte le società che intendano sviluppare software di simulazione di linguaggio. Non è infatti sufficiente la conoscenza tecnica per assicurare la commercializzazione di un prodotto di successo, ma anche la certezza del pieno rispetto di tutti gli ambiti del diritto coinvolti nello sviluppo e nei rapporti con l’utente finale.

Gli specialisti di NetworkLex sono in grado di supportare in modo efficace startup e aziende che sviluppino prodotti nell’ambito dell’intelligenza artificiale. Grazie alla particolare formazione multidisciplinare in ambito giuridico-informatico siamo infatti in grado di individuare fin dall’origine le peculiarità tecniche che siano potenzialmente fonte di criticità legali, assicurando una commercializzazione e un profitto privi di ostacoli inaspettati.